10 月 10 日消息,科技媒体 venturebeat 于 10 月 8 日发布博文,报道称三星高级 AI 研究院发布了名为微型递归模型(TRM)的开源 AI 模型,仅包含 700 万个参数,不过在数独、迷宫等特定的结构化推理任务上,表现媲美甚至超越了参数量为其 10000 倍的谷歌 Gemini 2.5 Pro 等顶尖大模型。

该 AI 模型由三星高级 AI 研究院(SAIT)高级 AI 研究员 Alexia Jolicoeur-Martineau 发布,成为 AI 领域“小模型”对抗“大模型”的趋势的重磅新案例。

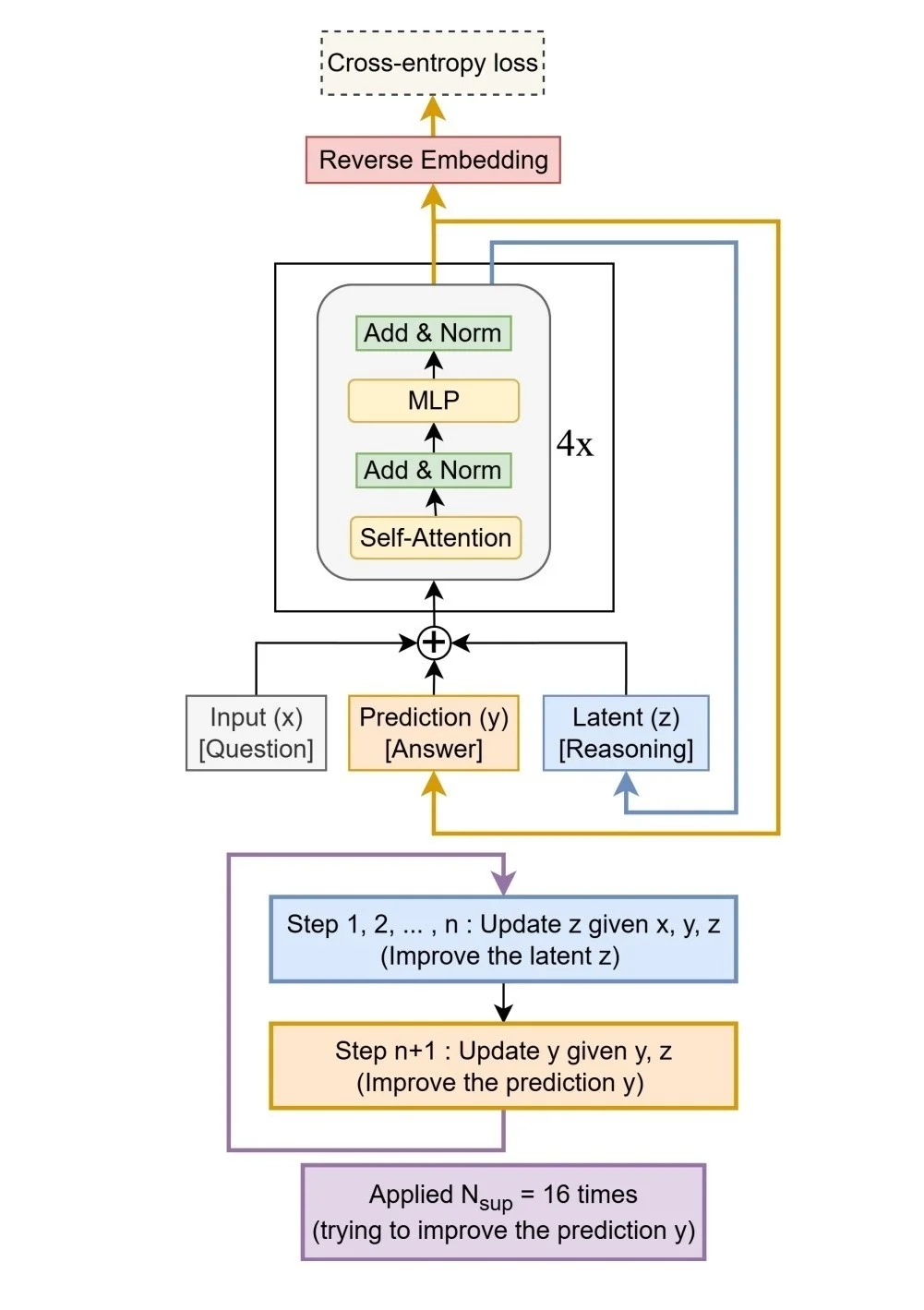

该模型仅有 700 万参数,设计理念是极致简化复杂性。在架构方面,摒弃了分层推理模型(HRM)所依赖的双网络协作架构,转而采用一个仅有两层的单一模型。

其核心机制在于“递归推理”:模型对自身输出的预测进行反复迭代和修正,每一步都纠正前一步的潜在错误,直至答案收敛稳定。

TRM 通过这种方式,用迭代计算的深度模拟了庞大网络的复杂推理过程,实现了“以递归替代规模”的目标,从而在不牺牲性能的前提下,大幅降低了计算和内存成本。

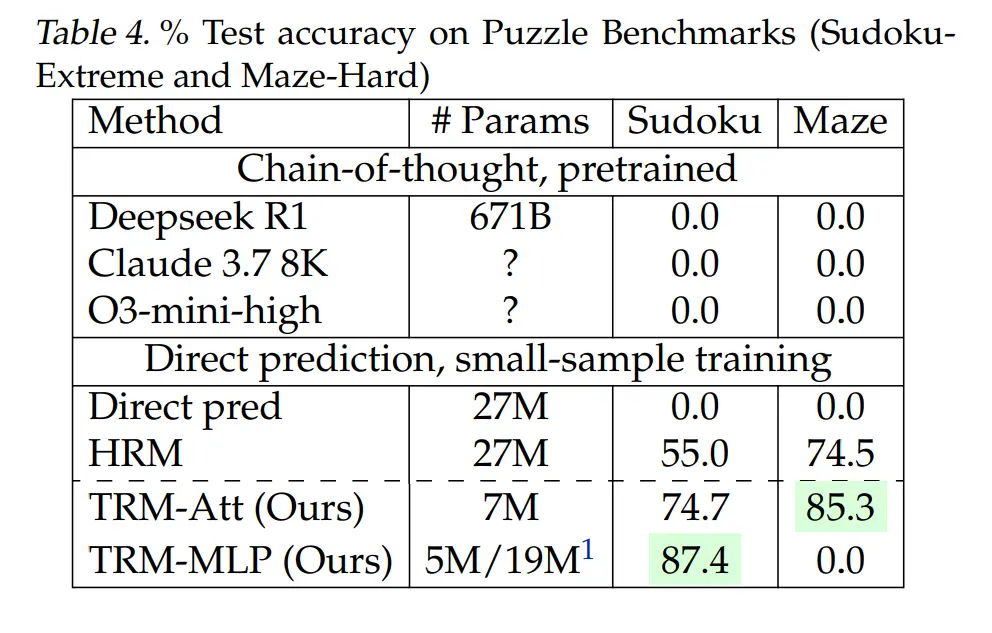

尽管模型极小,TRM 在多个基准测试中展现了“以小博大”的惊人实力:

在 Sudoku-Extreme(极限数独)测试中,其准确率达到 87.4%;

在 Maze-Hard(困难迷宫)中达到 85%;

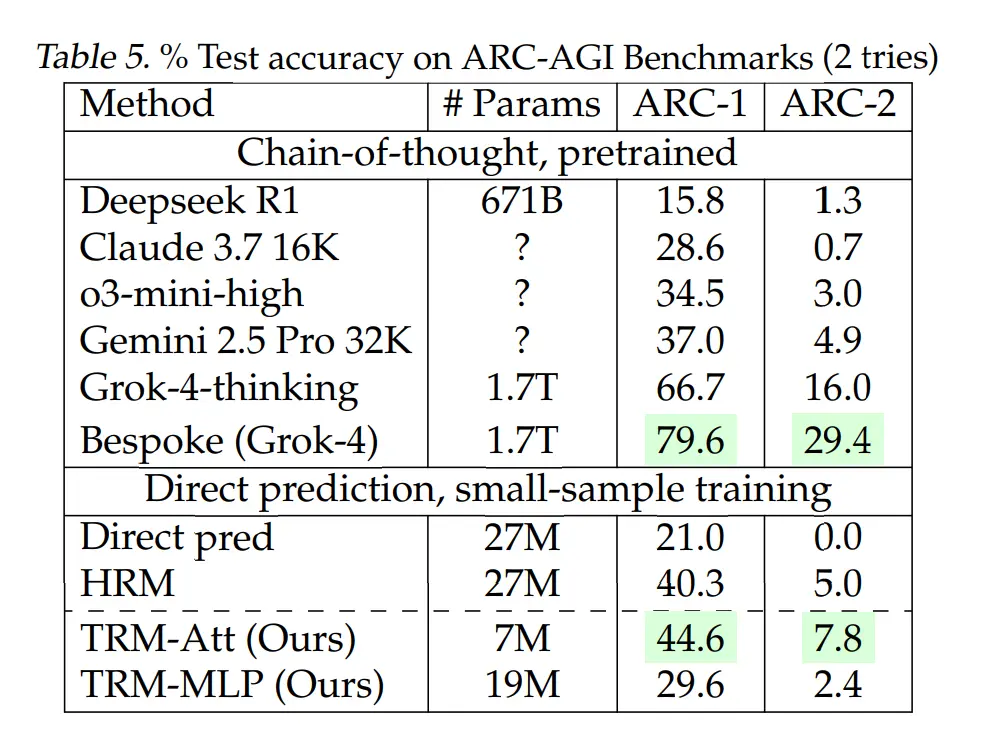

在衡量抽象推理能力的 ARC-AGI 测试中准确率为 45%;

ARC-AGI-2 的准确率为 8%。

尽管 TRM 使用的参数不到 0.01%,但这些结果仍然超过或接近几种高端大型语言模型的性能,包括 DeepSeek R1 、 Gemini 2.5 Pro 和 o3-mini 。

然而,一个重要的前提是,TRM 是专门为解决结构化、可视化的网格类问题(如数独、迷宫和特定解谜任务)而设计的,并非通用的语言聊天模型,它擅长在有明确规则的封闭环境中进行逻辑推理,而非开放式的语言生成。

TRM 的成功源于其刻意追求的“少即是多”极简主义设计。研究发现,增加模型层数或大小反而会导致在小数据集上出现过拟合,性能下降。其精简的双层结构与递归深度相结合,实现了最佳效果。

TRM 的代码、训练脚本和数据集目前已在 GitHub 上根据 MIT 许可证完全开源,企业和研究人员均可免费使用、修改和部署,甚至用于商业应用。

- 1000个官方媒体网站发布广告,每天百万人次曝光,帮您客户覆盖全国,业绩翻倍!

- 义乌爆单!全球采购商蜂拥而至

- 中药手串是真养生还是纯噱头

- 猛降20℃!全国乱穿衣地图出炉

- 华莱士正式宣布退市

- 何小鹏:应该向华为苹果等企业学习

- “龙虾”全网刷屏 劝你不要盲目跟风

- 7旬老人7天跑遍7大洲:目标跑到100岁

- 别把早午餐二合一

- 36岁,能开上这3款车就算小有成就

- 10万级SUV对决:宋Pro DM-i与埃安AION i60谁是优选?

- 投资人下班疯狂补习“养龙虾”

- 大学生寒假无休送外卖收入过万

- 中传一口气砍掉16个本科专业

- 黄金品牌涨价 50克金手镯贵了5万

- 超8成胖东来员工拒绝“降薪增假”

- Ella展示“真空腹” 震惊观众

- 初二男生贴助长贴一年长高11厘米

- 为什么中年男人去哪都要开车

- 包书皮真有必要吗